จากบทความก่อนหน้าทั้งภาคทฤษฎีและปฏิบัติของ Vector Embeddings ทำให้เราก้าวเข้าสู่เทคโนโลยี Gen AI กันอีกขั้น และวันนี้เรามาต่อยอดความรู้เหล่านั้นกันด้วย RAG ครับ

RAG คืออะไรและทำงานอย่างไร?

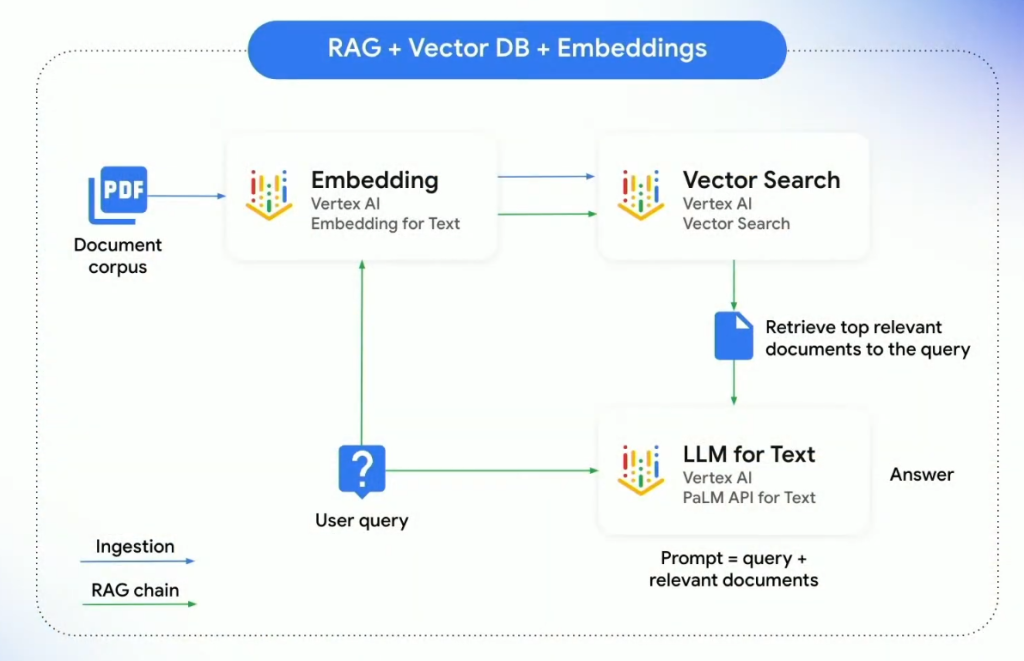

RAG ย่อมาจาก Retrieval Augmented Generation เป็นสถาปัตยกรรมแบบหนึ่งที่ใช้เทคนิค Grouding ที่เคยอธิบายในภาคทฤษฎีไปแล้ว โดยให้ตัว LLMs อ่านผลลัพธ์จาก Vector Search และทำการ Summarization ให้ โดยที่ LLMs ไม่จำเป็นต้องเชื่อมต่อกับข้อมูลเหล่านี้โดยตรง แต่เป็นการรับผลลัพธ์การค้นหาจาก Index ที่เป็นข้อมูลจริง ๆ ใน Database ของเรา ดังนั้นตัว LLMs จะไม่สับสน หรือสร้างข้อมูลที่ไม่ได้เกิดขึ้นจริง หรือความเสี่ยงที่จะเกิด Hallucinations เป็นต้น

กระบวนการ RAG ร่วมกับ Vector Search เป็นอย่างไร ?

- Embedding :

RAG จะแปลงข้อความค้นหา (Query) เป็น Vector โดยใช้ Embedding for Text - Vector Search :

นำ Query ที่ Embedding แล้วไป Search Vector ออกมาที่ Vector Search - LLM for Text :

LLMs สร้างข้อความใหม่โดยใช้ User Query และผลลัพธ์ของ Document ที่เกี่ยวข้องที่ได้มาจาก Vector Search ไป Summarization ด้วยโมเดลภาษา อาทิ Gemini และ PaLM2

ข้อดีของ RAG :

- ความแม่นยำ : RAG สามารถสร้างข้อความที่ตรงประเด็น และเกี่ยวข้องกับข้อความค้นหา

- ความหลากหลาย : RAG สามารถสร้างข้อความในรูปแบบต่าง ๆ เช่น บทความ สรุปบทความ บทกวี บทละคร ฯลฯ

- ความเร็ว : RAG สามารถสร้างข้อความสรุปและค้นหาได้อย่างรวดเร็ว

หากเราจะสร้าง RAG เองก็สามารถส่ง Document ที่เกี่ยวข้องจากผลลัพธ์ Vector Search ให้กับ Gemini Model ช่วย Summarization ได้ในเชิงปฏิบัติจริงเราอาจทำแอปฯ เอา GUI มาครอบต่อก็ได้

(ภาพประกอบนี้สร้างขึ้นด้วย Gemini)

ดังนั้นสถาปัตยกรรม RAG ก็เหมือนมี AI สาวที่ช่วยค้นหาหนังสือเล่มที่เราต้องการจากห้องสมุดอันใหญ่โตที่เราคงต้องใช้เวลานานทั้งวันในการค้นหาหรืออ่านให้ครบ แต่ AI ตัวนี้ก็สามารถหาหนังสือเล่มที่เราต้องการให้อย่างรวดเร็วพร้อมทั้งสรุปให้เราด้วยครับ

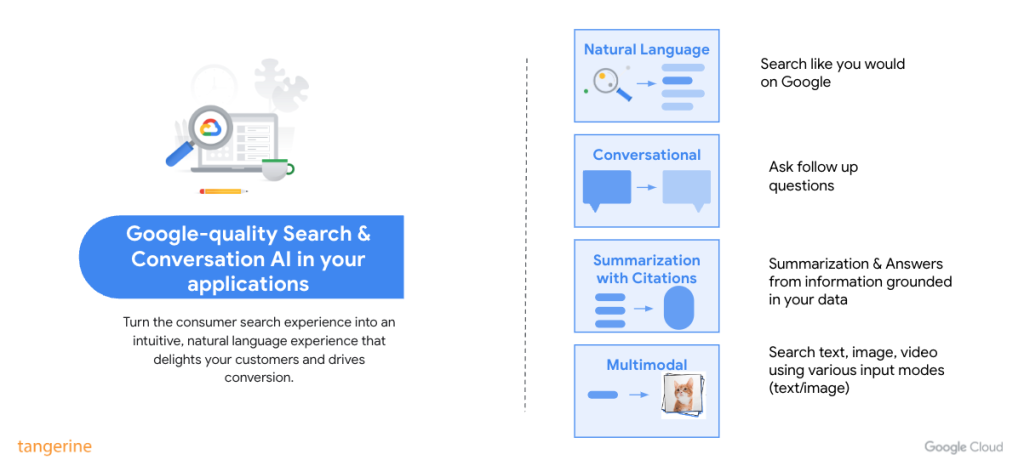

ในขณะเดียวกัน Google ก็ทำระบบที่ตอบโจทย์ RAG ขึ้นมาโดยไม่ต้องเขียนโปรแกรมมากนักมีชื่อว่า Vertex AI Search & Conversation ซึ่งผมแนะนำให้ทุกคนลองใช้เพราะทำ Use-cases RAG ได้ง่ายมาก

Vertex AI Search & Conversation คืออะไร?

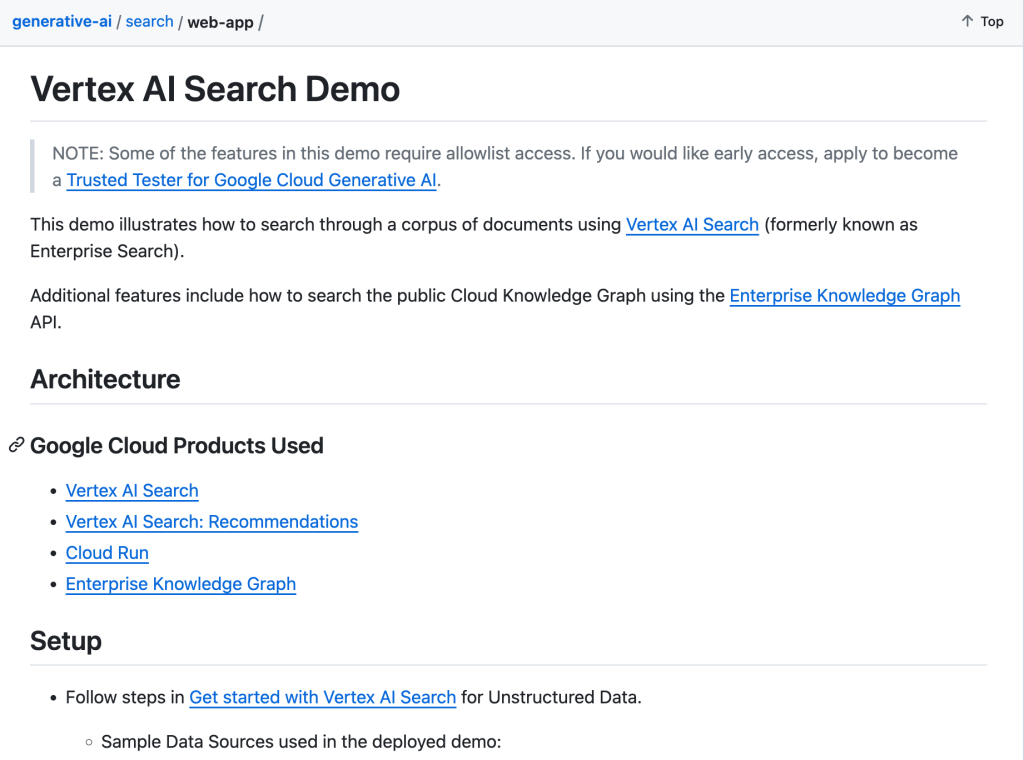

Vertex AI Search & Conversation เป็นบริการของ Google Cloud ที่ช่วยให้เราทำ Gen AI ที่เรียนรู้ข้อมูลในองค์กรมาตอบคำถาม และค้นหาเอกสารที่เกี่ยวข้อง เช่น PDF, Word และ CSV ได้โดยง่าย แค่เพียงลากข้อมูลไปวางบน Cloud Storage เท่านั้น ซึ่งชื่อเดิมของเจ้าตัวนี้คือ Gen App Builder

ดังนั้นการทำ Knowledge Search แบบ RAG จึงสามารถทำเป็นแอปฯ ได้ไม่กี่ชั่วโมง ซึ่งมี Use-cases ของนิตยสาร Forbes ใช้ตัว Vertex AI Search & Conversation มาสร้างตัว Adelaide และ POCs ในเวลา 2 สัปดาห์

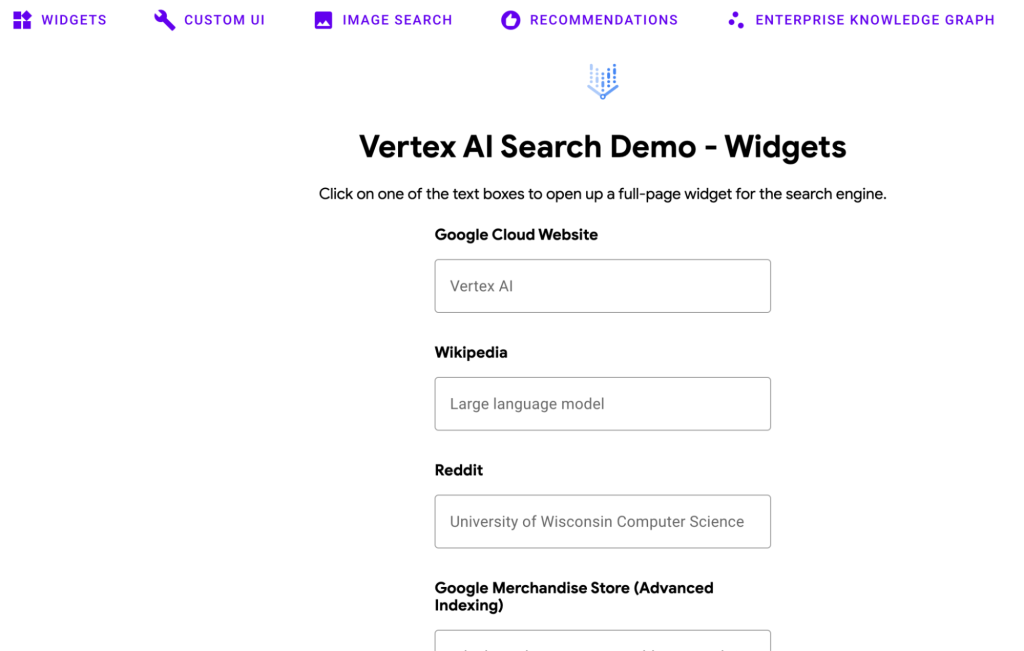

ทุกท่านก็สามารถมีแอปฯ แบบนี้ได้ด้วย Vertex AI Search & Conversation ซึ่งตัว Vertex AI Search จะ Provide เป็น APIs ในการค้นหา Query แค่เราทำแอปฯ ครอบ หรือจะใช้เป็น Widget สำเร็จรูปยัดใส่หน้าเว็บเราเลยก็ได้ครับ

ในส่วนของ Vertex AI Conversation ก็จะ Provide การค้นหาเป็นลักษณะ Chat นำไป Integrate กับ Chatbot Services ของ Google ได้ทันทีก็คือ Dialogflow CX ดังนั้น เจ้าตัว Dialogflow CX จะเก่งขึ้น ล้ำขึ้นอย่างมากครับ

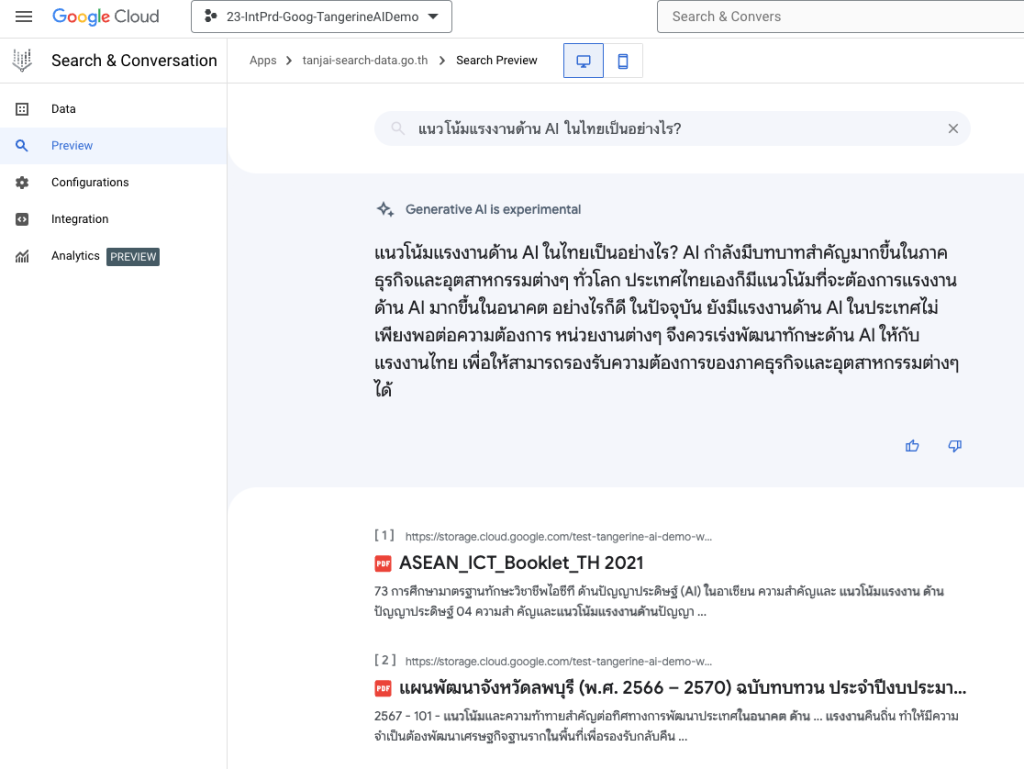

Vertex AI Search Demo

เพื่อความเข้าใจ เราสามารถลองเล่น Demo ที่ทาง Google ทำให้ผ่านลิงก์นี้ได้ครับ https://vertex-ai-search.web.app/

ตัว Vertex AI Search สามารถรับ Source ต่าง ๆ ได้มากมาย อาทิ Website, BigQuery และ Unstructured Data บน GCS ครับ ดังนั้นเราจึงสามารถทดลอง Query บน Demo ตัวนี้ได้เลย และหากต้องการทดลองทำเองทาง Google ก็มี Tutorial บน Github นี้ สามารถทำตามได้เลยครับ

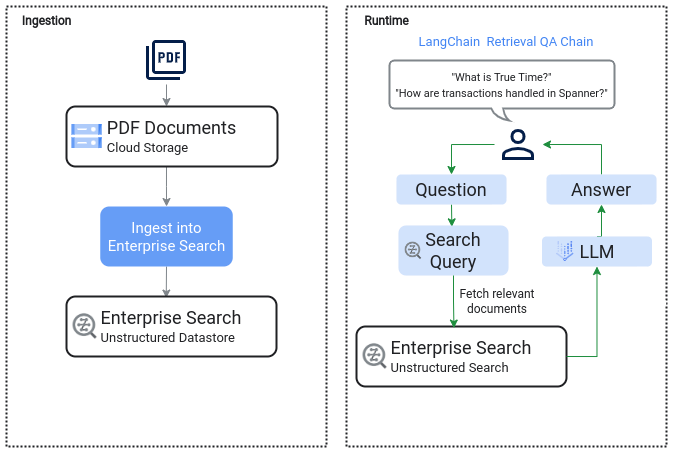

แปลว่ากระบวนการทำ RAG ในข้างต้นจะง่ายขึ้นเพราะไม่ต้องโค้ดอีกแล้ว แค่เตรียมไฟล์เหมือนในหัวข้อ Ingestion และ Query & Test ผ่านตัว Vertex AI Search ได้เลยเหมือน Architecture นี้ครับ

ผมขอขยายภาพ Ingestion ขึ้นนิดนึง จะเห็นว่าแค่เราวางไฟล์ PDF บน Cloud Storage ตัว Vertex AI Search ก็จะ Training ทำ Indexing ให้ครับ

ในส่วนของ Runtime เราก็สามารถทดสอบผลลัพธ์ใน Preview ได้เลย

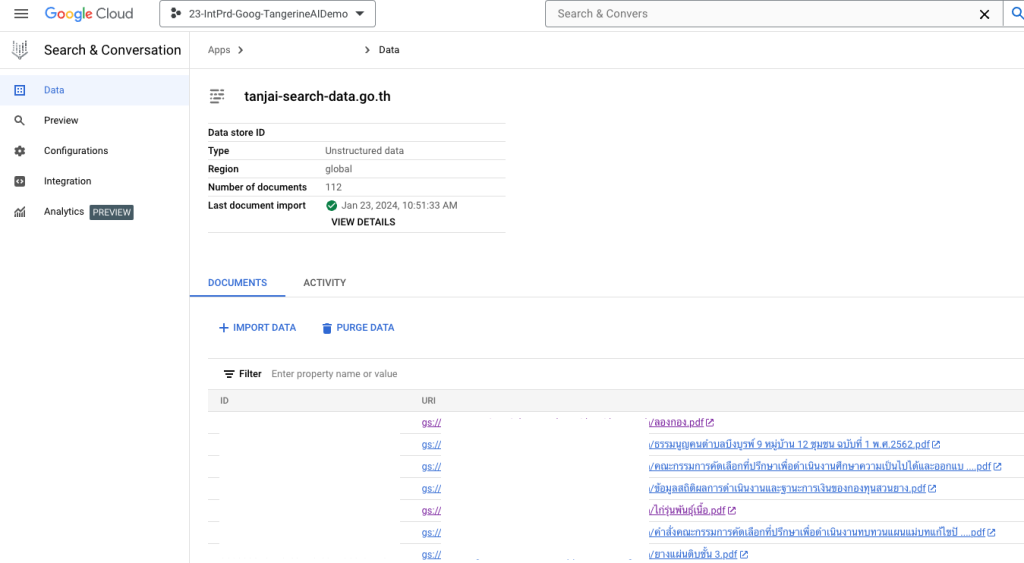

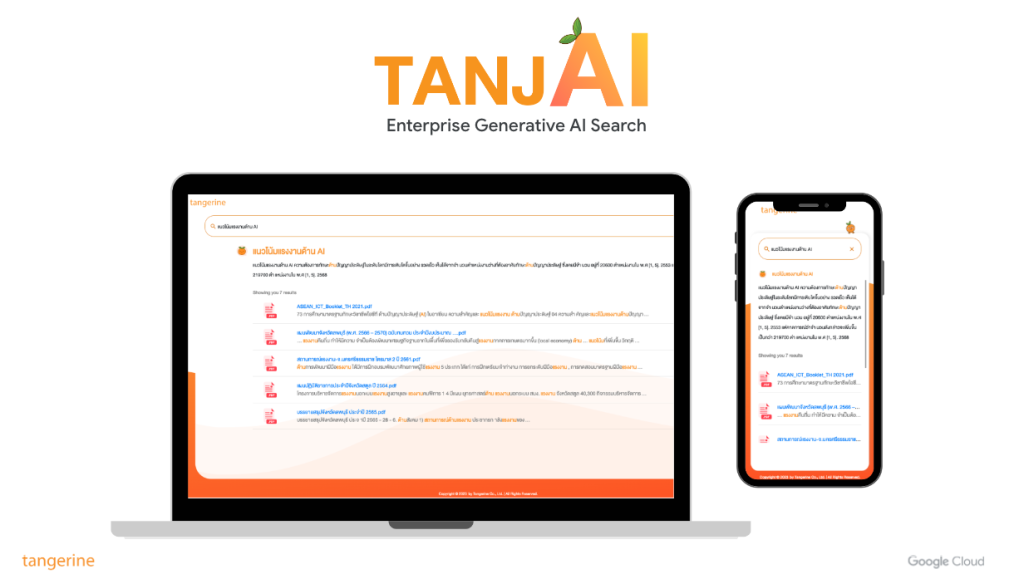

และหากไปประยุกต์ใช้ในองค์กรก็สามารถทำ UI มาครอบได้เป็น Intranet Search หรือ KM ตอบคำถามลูกค้า เช่น น้องแทนใจจากแทนเจอรีนครับ (TanjAI)

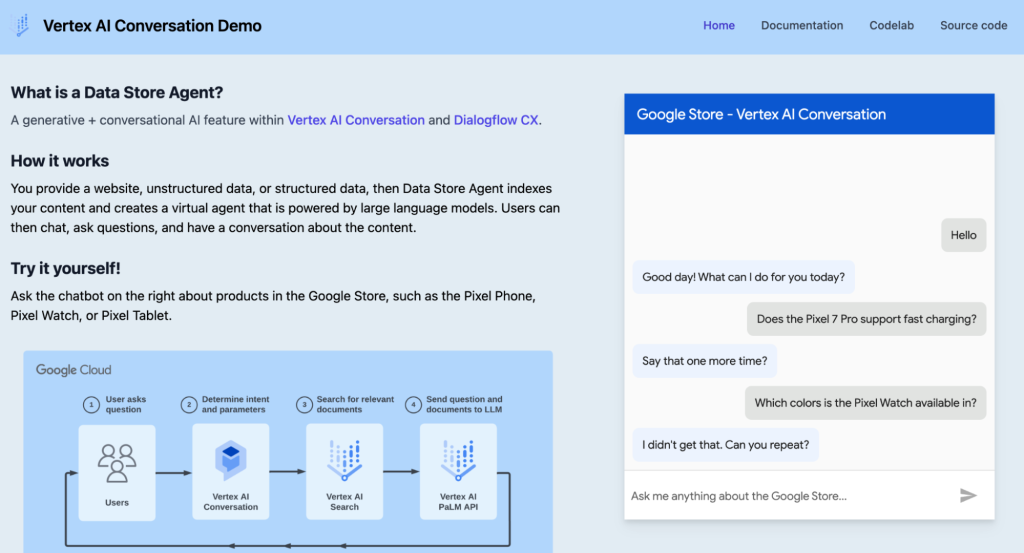

Vertex AI Conversation Demo

ในมุมของ Vertex AI Conversation บน Google Cloud ก็มี Demo ครับ ซึ่งสามารถดูได้ที่ https://vertex-ai-conversation.web.app/ เรียกว่าเป็น Use-cases สำเร็จที่ใช้ Dialogflow ต่อยอดกับ Vertex AI Search ออกมาได้ง่าย ๆ ครับ

หากให้แชร์ในมุมประสบการณ์ การทำแนว AI ตอบคำถามขององค์กรนั้น หากทำในรูปแบบ Web App จะทำได้เร็วกว่า และลงทุนน้อยกว่าทำแบบ Chabot ครับ เพราะในการทำ Chatbot ส่วนใหญ่จะปฏิสัมพันธ์ในรูปแบบ Text มากกว่าการทำ UI แบบ Web App ดังนั้นจึงต้องมีการออกแบบ Dialog Journey หรือการออกแบบ Intent ทำให้มีการพัฒนาที่ซับซ้อน และใช้ Cost สูงกว่า ดังนั้นหากเราเริ่มต้นแนะนำว่าให้ลองใช้ Vertex AI Search ก่อน เพื่อทำเป็น MVP ขององค์กรเราครับ

Conclusion

บริการ Vertex AI Search & Conversation ถือเป็น Game Changer ในการทำ RAG เพื่อใช้ในองค์กรแบบง่าย ถูก และดีครับ เมื่อเทียบกับการต้อง Build from Scratch เจ้าตัวนี้ถือว่าตอบโจทย์องค์กรที่จะนำเทคโนโลยี Generative AI มาใช้เป็นอย่างมากครับ และถ้าองค์กรต้องการมี AI แบบน้อง TanjAI ก็ไม่ใช่เรื่องยากอีกต่อไป สามารถปรึกษาผู้เชี่ยวชาญจากแทนเจอรีนได้ทันทีครับ