สวัสดีนักพัฒนาโดยเฉพาะ ‘Prompt Engineer’ ทุกท่าน เรื่องน่าตื่นเต้นต้อนรับปี 2025 นี้คงหนีไม่พ้นการเปิดตัว Gemini 2.0 วันนี้พวกเราทีม Tangerine รู้สึกตื่นเต้นมากที่จะมาแชร์ประสบการณ์เกี่ยวกับความสามารถใหม่ของ Gemini 2.0 และ Use case เจ๋ง ๆ ที่คุณสามารถนำไปประยุกต์ใช้ได้ ไปดูกันเลย !

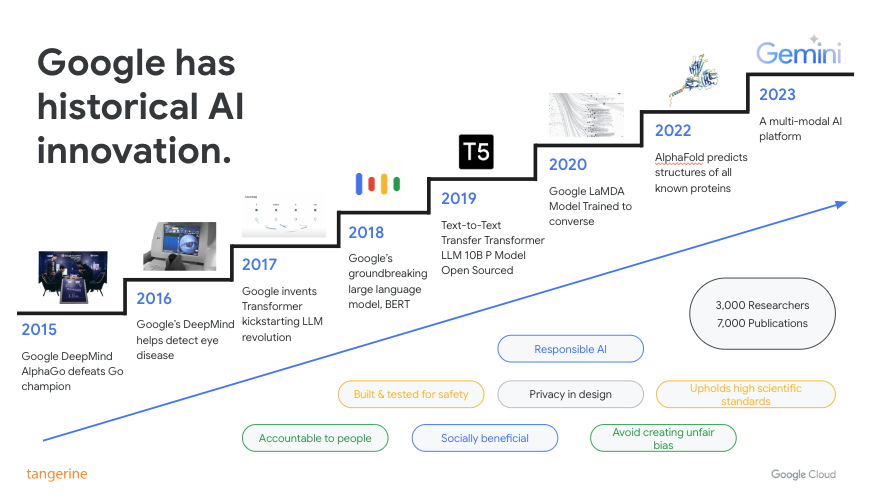

การเดินทางของ Gemini

เส้นทางของ Gemini เริ่มขึ้นเมื่อ Google rebranding Bard สู่ Gemini 1.0 model สุดล้ำและชาญฉลาดรองรับงานที่ซับซ้อนได้ในปี 2023 และสะเทือนวงการอีกครั้งในต้นปี 2024 ก็เปิดตัว Gemini 1.5 ที่รองรับ Context window ที่ใหญ่ที่สุดในโลกนับตั้งแต่มีมาพร้อมด้วยสถาปัตยกรรมแบบ MoE

ในวันนี้ทาง Google ก็ประกาศ Gemini 2.0 Flash ในปลายปี 2024 เปรียบเสมือนของขวัญปีใหม่ 2025 ต้อนรับเหล่านักพัฒนาทุกคน ซึ่งจะช่วยสร้างแอปพลิเคชันที่ดื่มด่ำและโต้ตอบได้ดียิ่งขึ้น มาพร้อมกับ Native tools จาก Google อย่าง Google Search และ Code Execution เป็นต้น

สร้างสรรค์สิ่งใหม่ด้วย Gemini 2.0 Flash

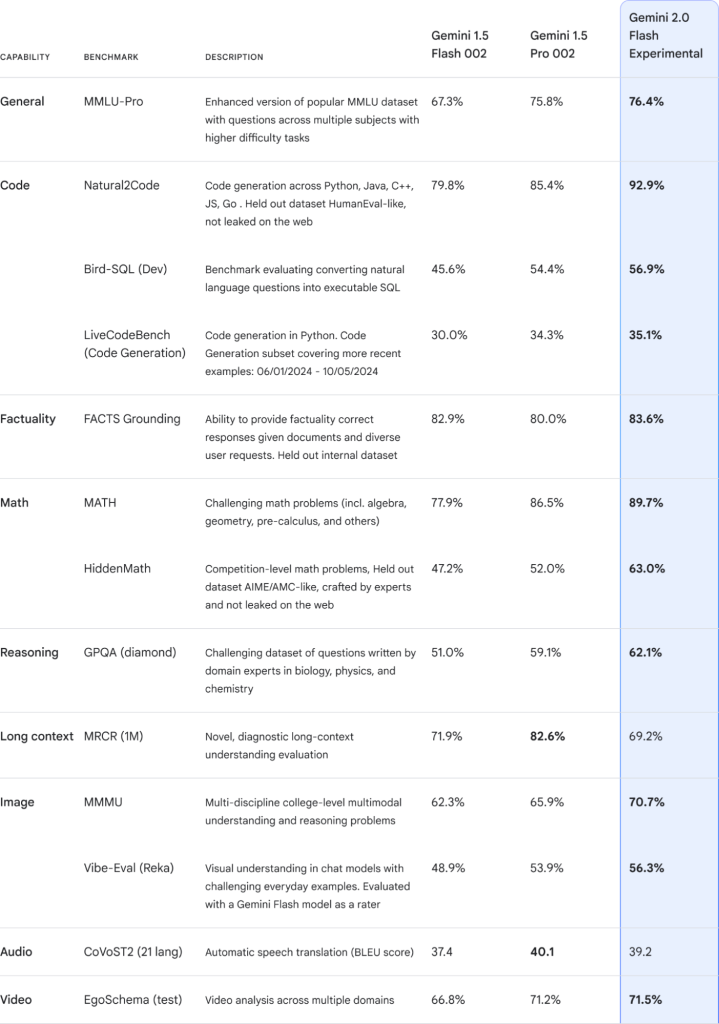

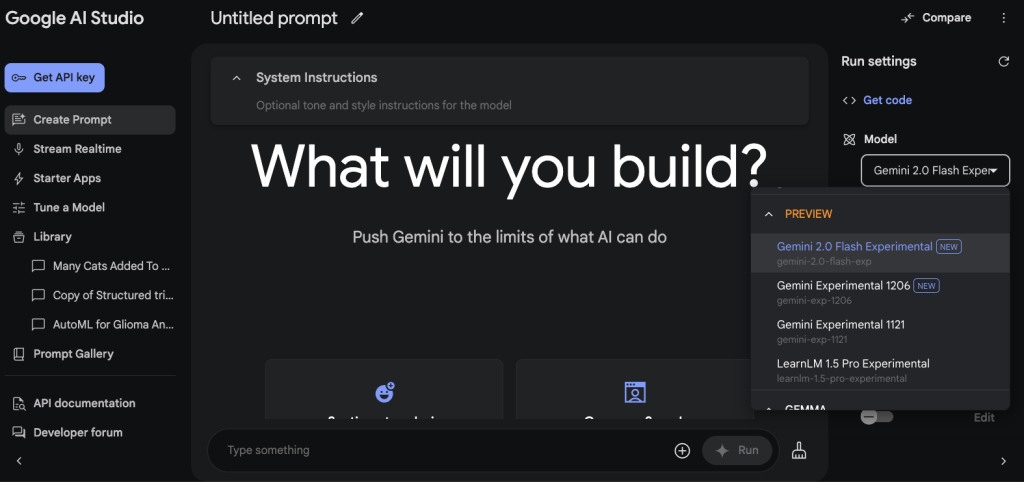

Gemini 2.0 Flash นั้นมีความเร็วที่ดีขึ้นกว่า Gemini 1.5 Flash แต่หากเทียบกับ Gemini 1.5 Pro แล้ว ตัว Gemini 2.0 Flash จะเร็วกว่า 2 เท่าครับ นอกจากนั้น Highlight คือสามารถ Output แบบ Multimodal ได้ที่ไม่ใช่แค่ Text มาพร้อม Tools ต่าง ๆ ที่ทำให้นักพัฒนาทำงานได้อย่างราบรื่น รวมถึงการเปิดตัว Multimodal Live API ทำให้เราสามารถสร้าง Real-time application ได้อย่างการสตรีมเสียงหรือวิดีโอเข้าไป ซึ่งเราสามารถใช้ Gemini 2.0 Flash ได้แล้วที่ Google AI Studio และ Vertex AI

Gemini 2.0 Flash บน Google AI Studio

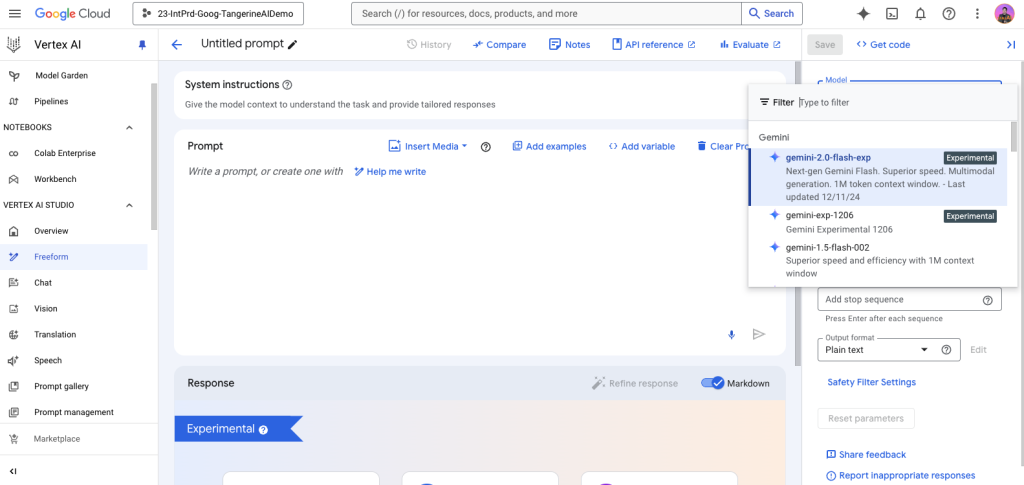

Gemini 2.0 Flash บน Vertex AI Studio

ความเข้าใจแบบ Multimodal ของ Gemini 2.0 คืออะไร ?

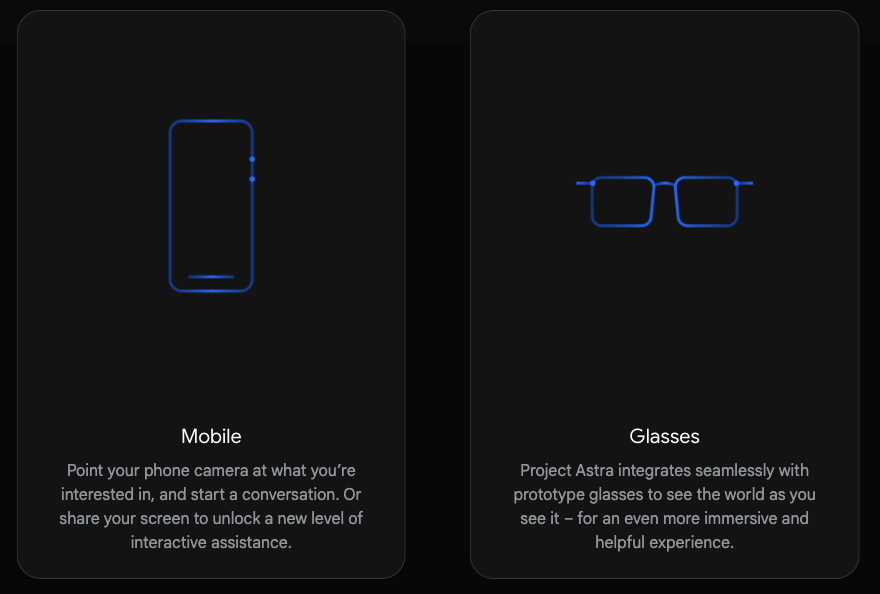

ความเข้าใจแบบ Multimodal หมายถึงความสามารถของ AI ในการประมวลผลและทำความเข้าใจข้อมูลที่หลากหลายรูปแบบ ไม่ว่าจะเป็น ข้อความ รูปภาพ เสียง หรือแม้แต่วิดีโอ โดย AI จะสามารถเชื่อมโยงข้อมูลเหล่านี้เข้าด้วยกัน เพื่อให้ได้ผลลัพธ์ที่ครอบคลุมและแม่นยำยิ่งขึ้น นำมาสู่ Project Astra ของทาง Google ที่สามารถเชื่อมโยง AI เหล่านี้เข้าสู่ชีวิตจริงของมนุษย์ผ่าน Device เหล่านี้

เรามารู้จักกับ Project Astra ที่ขับเคลื่อนด้วย Multimodal Understanding กันครับ

ฟีเจอร์เด่นของ Gemini 2.0 Flash

ประสิทธิภาพที่เหนือกว่า

Gemini 2.0 Flash ทรงพลังกว่า 1.5 Pro แต่ยังคงไว้ซึ่งความเร็วและประสิทธิภาพที่นักพัฒนาคาดหวังจาก Flash นอกจากนี้ ยังมีการปรับปรุงประสิทธิภาพในการทำงานกับข้อความ โค้ด วิดีโอ การรับรู้เชิงพื้นที่ (Spatial Understanding) และการใช้เหตุผล (Reasoning) การรับรู้เชิงพื้นที่ที่ดีขึ้น ช่วยให้สร้าง Bounding box ได้แม่นยำยิ่งขึ้นสำหรับวัตถุขนาดเล็กในภาพที่ซับซ้อน รวมถึงการระบุและบรรยายวัตถุได้ดีขึ้น

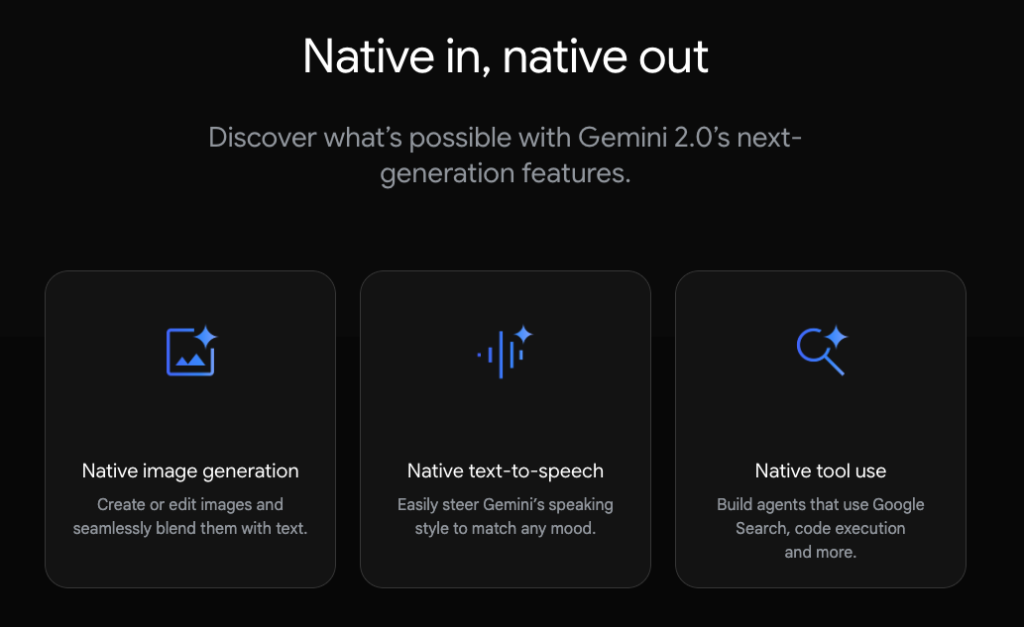

Output แบบใหม่ที่เป็น Multimodal

นักพัฒนาสามารถใช้ Gemini 2.0 Flash เพื่อสร้างประสบการณ์ที่หลากหลาย ตั้งแต่ข้อความ เสียง และรูปภาพ ผ่านการเรียกใช้ API เพียงครั้งเดียว ไม่จำเป็นต้องเรียก Foundation Model ตัวอื่น ๆ แล้ว

Native tool use

Gemini 2.0 ได้รับการฝึกฝนให้สามารถใช้งานเครื่องมือต่าง ๆ ซึ่งเป็นพื้นฐานสำคัญในการสร้างประสบการณ์แบบ Agentic (การกระทำแทนมนุษย์) คือสามารถเรียกใช้เครื่องมือต่าง ๆ ได้โดยตรงเหมือนการเรียกใช้ APIs เช่น Google Search, Code execution, Function calling และอื่น ๆ

ปลดล็อกประสบการณ์ Multimodal แบบ Real-time

ผู้พัฒนาสามารถสร้าง Real-time application เช่น Streaming ภาพหน้าจอหรือกล้อง และสร้างบทสนทนาที่เป็นธรรมชาติมากขึ้นได้ เช่น การพูดแทรก หรือการตรวจจับเสียง ซึ่งเราสามารถลองติดตั้ง Demo use case นี้ผ่าน Github Multimodal Live API – Web console นี้ได้เลยครับ

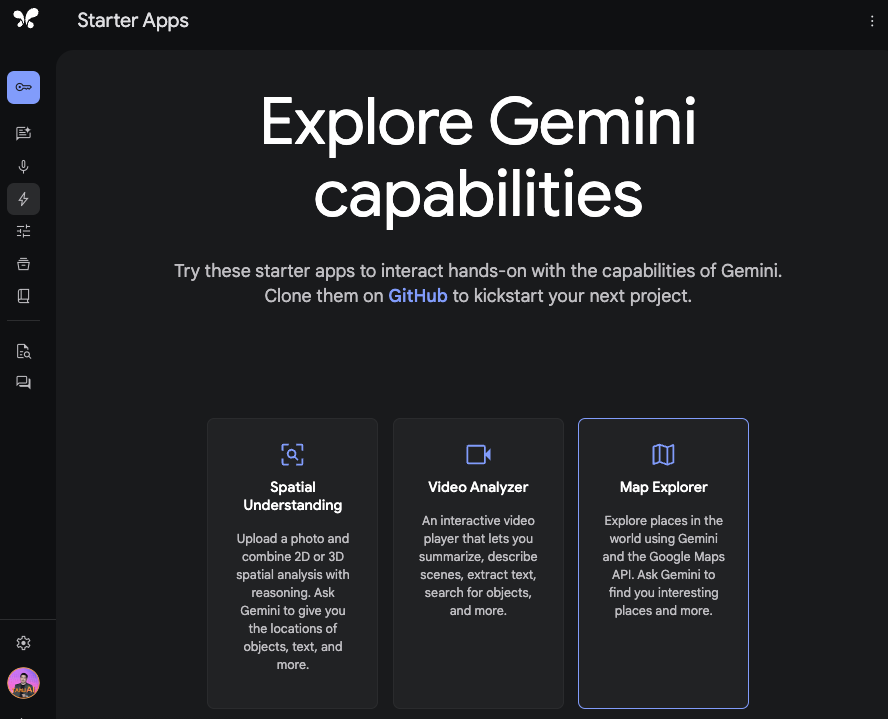

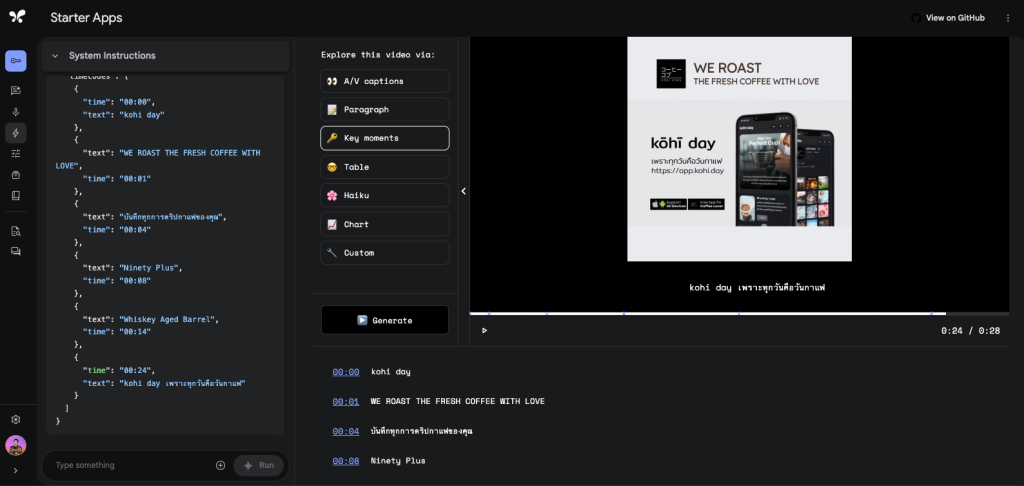

หรือหากต้องการทดลองใช้ประสบการณ์แบบ Multimodal นี้ ทาง Google ก็ทำ Starter Apps ให้พวกเราเล่นบน Google AI Studio ครับ

ลองทดลองใช้ Video Analyzer กับวิดีโอตัวอย่างของเราก็ได้ครับ เช่น ตัวอย่างต่อไปนี้ในการหา Key moments ของวิดีโอพบว่า Gemini 2.0 Flash สามารถตอบสนองได้ดีและเร็ว ในส่วนของ Tools ก็ง่ายที่จะนำ Concept idea ที่ทำบน Google AI Studio ไปพัฒนาเป็น Application ต่อ

สรุป Features เด่นของ Gemini 2.0 Flash

Gemini 2.0 Flash ในปลายปี 2024 เป็นรุ่นทดลอง (Experimental) ที่เปิดตัวผ่าน Gemini Developer API, Google AI Studio และ Vertex AI Studio มีจุดเด่นดังนี้

- Multimodal Live API: สร้างแอปพลิเคชันแบบ Real-time ที่รับรู้ทั้งเสียงและภาพ

- Speed and Performance: รวดเร็วกว่า Gemini 1.5 Flash อย่างเห็นได้ชัด

- Quality: ประสิทธิภาพสูงกว่า Gemini 1.5 Pro ในหลายด้าน

- Agentic Capabilities: ปรับปรุงการทำความเข้าใจแบบมัลติโมดัล การเขียนโค้ด การทำตามคำสั่งที่ซับซ้อน และการเรียกใช้ฟังก์ชันภายนอกที่ Custom เองได้

- New modalities: เพิ่มการสร้างรูปภาพแบบการสร้างเสียงสังเคราะห์ได้

หากคุณต้องการข้อมูลเชิงลึกเกี่ยวกับ Gemini หรือต้องการปรึกษาในเรื่องของการ Gemini ไปประยุกต์ใช้ในองค์กร

สามารถปรึกษาทีมผู้เชี่ยวชาญจาก Tangerine ได้พื่อรับคำปรึกษาได้เลยครับ